Rapport du BSIF et de l'ACFC - L'IA dans les institutions financières fédérales : utilisations et risques

Table des matières

1 Introduction

1.1 Contexte et objet du rapport

Face à l'essor fulgurant de l'intelligence artificielle (IA), le Bureau du surintendant des institutions financières (BSIF) et l'Agence de la consommation en matière financière du Canada (ACFC) suivent l'évolution des risques et plaident en faveur d'une utilisation responsable de l'IA. En 2022, le Bureau du surintendant des institutions financières (BSIF) avait organisé, avec le Global Risk Institute (GRI, ou en français, l'Institut du risque mondial), un Forum sur l'intelligence artificielle dans le secteur des services financiers (FIASSF). Les conclusions de ce colloque sont rassemblées dans un rapport, publié sous le titre « Une perspective canadienne sur l'intelligence artificielle responsable », qui présente les principes EDGE (explicabilité, données, gouvernance et éthique) comme pierre angulaire de l'utilisation responsable de l'IA.

En décembre 2023, le BSIF et l'ACFC avaient invité les institutions financières fédérales (institutions financières) à remplir un questionnaire sur l'IA et sur leur niveau de préparation à l'informatique quantique. En avril 2024, le BSIF a consacré un numéro de son Bulletin sur le risque lié aux technologies à la préparation des institutions financières à l'informatique quantique.

Publié dans la foulée de ce bulletin à partir des conclusions tirées des réponses au questionnaire et de l'analyse d'un certain nombre de publications externes, le présent rapport fait le point sur les principaux risques que l'IA fait peser sur les institutions financières. Ceux-ci peuvent venir tant de l'adoption de l'IA à l'interne que de son utilisation par des acteurs externes.

Il se penche également sur certaines pratiques susceptibles de limiter certains de ces risques. Il ne faut pas y voir une injonction, mais plutôt un pas dans la bonne direction dans le cheminement des institutions financières vers une meilleure gestion des risques liés à l'IA.

Précisons que l'utilisation du terme « IA » recouvre ici tout un éventail d'algorithmes, de méthodologies de modélisation et de systèmes d'apprentissage automatique. Il convient de garder à l'esprit que les risques et les problèmes pour les clients peuvent sensiblement varier en fonction du type de modèles et d'algorithmes d'IA utilisés.

1.2 L'utilisation de l'IA dans les institutions financières

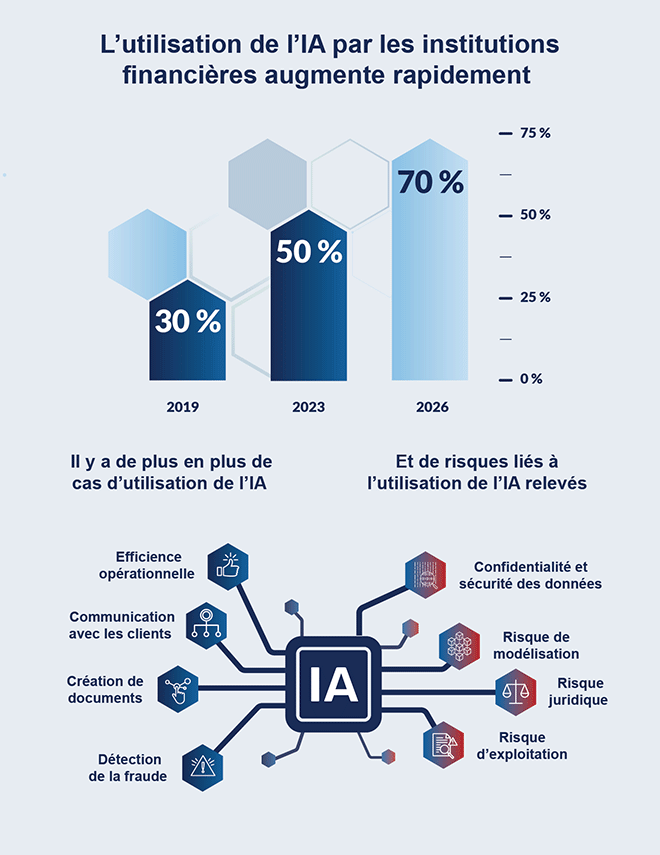

Les chiffres figurant dans l'illustration ci-dessous sont tirés des réponses au questionnaire.

Utilisation de l'IA par les institutions financières - Version textuelle

L'utilisation de l'IA par les institutions financières augmente rapidement :

- En 2019, environ 30 % des institutions financières fédérales utilisaient l'IA.

- En 2023, environ 50 % des institutions financières fédérales utilisaient l'IA.

- D'ici 2026, environ 70 % des institutions financières fédérales prévoient d'utiliser l'IA.

Il y a de plus en plus de cas d'utilisation de l'IA, accompagnés de risques de plus en plus importants.

Principaux cas d'utilisation de l'IA :

- Efficacité opérationnelle

- Communication avec les clients

- Création de documents

- Détection de la fraude

Principaux risques liés à l'utilisation de l'IA :

- Confidentialité et sécurité des données

- Risque de modélisation

- Risque juridique

- Risque d'exploitation

1.3 Sommaire

Avec l'IA, les institutions financières ne peuvent plus exercer leurs activités ni gérer les risques de la même façon. Si elle peut les aider à mieux communiquer avec leurs clients et à mieux gérer les risques, à améliorer leur processus décisionnel et leur efficacité opérationnelle, elle peut également accentuer certains risques traditionnels et exposer de nouvelles lacunes. On ne peut plus le nier : l'IA bouleversera le système financier, que les institutions financières décident d'embarquer ou pas.

Risques internes

Les réponses au questionnaire traduisent une augmentation substantielle des investissements en IA et du recours aux modèles d'IA depuis notre coup de sonde de 2019. Les applications, le nombre d'employés affectés à l'IA et les méthodes de gestion du risque sont tous en hausse. L'IA générativeNote de bas de page 1, de par sa flexibilité et sa facilité d'utilisation, y est pour beaucoup.

Les institutions financières utilisent désormais l'IA dans des domaines plus importants, comme la tarification, la sélection des risques, la gestion des sinistres, la négociation, les décisions de placement et les octrois de crédit. Le recours à l'IA peut accentuer les risques liés à la gouvernance de données, à la modélisation, aux opérations et à la cybersécurité. Le risque lié aux tiers augmente également lorsque les institutions financières font appel à des fournisseurs externes pour leurs solutions d'IA. L'incidence sur le client de l'utilisation de l'IA pourra également donner lieu à de nouveaux risques juridiques et d'atteinte à la réputation qui peuvent toucher les institutions financières qui ne se seront pas dotées de mécanismes de protection et de reddition de comptes adéquats.

Les institutions financières se sentent également dans l'obligation d'adopter l'IA en réponse aux pressions concurrentielles, ce qui peut les amener à prendre davantage de risques stratégiques ou d'exploitation. Elles doivent faire preuve de vigilance et se doter de cadres de gestion du risque et de contrôle adaptables pour pouvoir faire face aux risques internes liés à l'IA.

Risques externes

L'intelligence artificielle continue de progresser à une vitesse fulgurante. Les modèles d'IA générative accomplissent déjà de nombreuses tâches aussi bien que l'être humain (en anglais seulement)Note de bas de page 2. Les acteurs malveillants se servent de l'IA pour lancer des attaques toujours plus sophistiquées contre les institutions financières. Parce que les attaques sont désormais plus faciles à concevoir et qu'elles peuvent être exécutées plus rapidement, les fraudeurs ne ciblent plus uniquement les grandes institutions. Chaque attaque leur revient moins chère à mettre en œuvre, si bien que les petites institutions sont désormais elles aussi des cibles de choix.

Les cas de fraude gagnent en fréquence et sont de plus en plus difficiles à repérerNote de bas de page 3. La généralisation de l'IA risque de se traduire par une accélération des risques de marché et de liquidité, et donc par une augmentation de la volatilité et des effets de récursivité sur les marchés financiers.

L'adoption de l'IA peut par ailleurs s'accompagner de phénomènes de mésinformation et de désinformation de nature à accentuer les risques géopolitiques. Ses répercussions macroéconomiques à moyen terme sur les marchés de l'emploi et sur les différents secteurs pourraient également se traduire par une augmentation du risque de crédit.

Toutes les institutions financières, qu'elles optent pour l'IA ou pas, doivent être au fait de l'évolution des risques. Ceux-ci augmentent rapidement et il y a plus d'une façon d'y faire face, et il appartient aux institutions financières de recenser et de combler leurs lacunes en la matière.

Le point de vue du BSIF et de l'ACFC

Le BSIF et l'ACFC savent qu'il n'est pas toujours facile de faire face aux risques liés à l'IA. Il y a parfois des arbitrages délicats à opérer, entre les questions de confidentialité des données et de gouvernance et la nécessité de disposer de modèles explicables, transparents et non biaisés, par exemple. Nous travaillons ensemble pour surveiller activement l'évolution de l'environnement de risque et encourageons les institutions financières à se doter de pratiques exemplaires en la matière. Nous collaborons régulièrement avec les autorités de réglementation d'autres pays, ainsi qu'avec d'autres organismes gouvernementaux et ministères. Nous souscrivons à un certain nombre de lignes directrices ou codes de déontologie sur l'IA du gouvernement du Canada applicables au secteur financier (le Code de conduite volontaire visant un développement et une gestion responsables des systèmes d'IA générative avancés; les Principes pour des technologies de l'intelligence artificielle (IA) générative responsables, dignes de confiance et respectueuses de la vie privée; la Directive sur la prise de décisions automatisée; et la Loi sur l'intelligence artificielle et les données).

Les cadres réglementaires du BSIF et de l'ACFC contiennent déjà des recommandations sur de nombreux risques prudentiels liés à la mise en place de l'IA. Ils portent notamment sur les lois et règlements sur la protection des consommateurs, sur les directives sur la gestion du risque de modélisationNote de bas de page 4, sur la gestion du risque lié aux tiersNote de bas de page 5, sur la cybersécuritéNote de bas de page 6 et sur la résilience opérationnelleNote de bas de page 7, qui sont tous neutres sur le plan technologique.

2 Utilisation de l'IA à l'interne

L'utilisation de l'IA est appelée à continuer à croître et elle touchera tous les pans des institutions financières. Les réponses au questionnaire montrent que, pour beaucoup d'entre elles, l'IA est désormais incontournable dans la course aux avantages concurrentiels et à la création de valeur.

2.1 Hausse des taux d'adoption et des investissements dans l'IA

Parmi les institutions financières qui ont répondu au questionnaire, 75 % estiment que l'IA constitue désormais une priorité stratégique et ont l'intention de lui consacrer des investissements au cours des trois prochaines années. Beaucoup font affaire avec des prestataires externes. Par ailleurs, 70 % prévoient utiliser des modèles d'IA au cours de la même période. Parmi les 30 % restants, certaines envisagent néanmoins d'évaluer les risques d'entreprise liés à l'IA au cas où elles devraient y recourir par la suite. Selon Fortune Business Insights, le marché mondial de l'IA devrait passer de 621 milliards de dollars US en 2024 à 2700 milliards de dollars US d'ici 2032 (en anglais seulement).

2.2 Activités touchées par les modèles d'IA

L'IA est de plus en plus présente dans les fonctions essentielles comme la sélection des risques et la gestion des sinistres. Environ un quart des assureurs indiquent que l'IA leur sert principalement à ces deux fonctions. Les institutions de dépôt (ID) intègrent elles aussi de plus en plus l'IA à leurs fonctions essentielles comme la négociation algorithmique, la gestion de la liquidité, les activités liées au risque de crédit et le suivi de la conformité.

Nombre d'institutions financières se servent de l'IA pour détecter les fraudes, à commencer par les ID, pour lesquelles il s'agit d'une de leurs principales applications. Les sociétés d'assurance en font également le même usage. Les institutions financières font également souvent appel à l'IA, souvent avec l'aide de fournisseurs externes, dans le domaine de la cybersécurité. Elle peut aider à détecter les anomalies de réseau et à repérer les courriels suspects (hameçonnage ou logiciels malveillants) et les éventuels cas de fraude.

Les effets de l'IA se font singulièrement sentir dans l'efficacité opérationnelle et dans les domaines impliquant des contacts avec les clients, où le nombre d'activités concernées devrait se multiplier au cours des trois prochaines années. Les domaines impliquant des contacts avec les clients qui font appel à l'IA incluent le recours à des robots conversationnels en soutien au service à la clientèle, la vérification des clients, les applications marketing et les conseils financiers personnalisés.

L'IA générative explique une bonne partie de l'augmentation du recours à l'IA. Elle offre différentes applications comme l'aide au codage, la production de texte, la synthèse de documents, la recherche de renseignements et la transcription des procès-verbaux de réunions. Les institutions financières ayant répondu au questionnaire utilisent différentes solutions d'IA générative externes, comme les modèles de ChatGPT, Microsoft Copilot, Azure OpenAI, GitHub Copilot, Amazon Web Services et Llama. La plupart des institutions financières, à commencer par les plus petites, en sont au stade du prototype. Certaines ont commencé à faire le tour des grands modèles de langage (GML) en vue de différentes utilisations (personnalisation pour une utilisation à l'interne, contacts avec les clients, etc.). Quelques-unes en sont encore à évaluer les risques et les avantages de l'IA générative.

3 Risques internes

L'IA comportant différents types de risques, elle peut être considérée comme un risque transversal. Elle pourrait contribuer à amplifier les risques existants et en faire apparaître de nouveaux à mesure que son utilisation augmentera et que la collecte de données et les modèles s'étendront à de nouveaux domaines. Des lacunes en matière de gestion des risques peuvent apparaître lorsque les compétences, les mesures de contrôle et les procédures peinent à suivre et à s'adapter.

3.1 Risques liés à la gouvernance de données

Les risques liés aux donnéesNote de bas de page 8 constituent une des principales problématiques entourant l'utilisation de l'IA, selon les répondants. Ces risques sont présents tout au long du cycle de vie des donnéesNote de bas de page 9 et concernent autant la confidentialité que la gouvernance et la qualité des données. Les différences de réglementation d'un territoire à l'autre, le morcellement de la propriété des données et les ententes avec des tiers peuvent représenter un défi. La question de la gouvernance de données est un incontournable dans le domaine de l'IA; elle pourra passer par des cadres généraux de gouvernance de données, par une gouvernance de données spécifique à l'IA ou par des cadres de gestion du risque de modélisation.

Une mauvaise utilisation de données synthétiques peut avoir de graves conséquences sur les institutions financières. Certaines se servent déjà de ce type de données à des fins de modélisation, et d'autres envisagent d'y recourir dans les prochaines années. Le phénomène est certes encore récent, mais il faudra que les institutions financières se dotent de normes pour évaluer et assurer la fidélité des données synthétiques utilisées dans les systèmes d'IA.

3.2 Risque de modélisation et explicabilité

Les modèles d'IA sont très risqués en raison de leur complexité et de leur opacité. Contrairement aux modèles traditionnelsNote de bas de page 10, ils comportent généralement beaucoup plus de paramètres, lesquels sont calibrés de manière autonome à partir de données. Outre les problèmes d'infrastructures et de données, les liens de causalité entre les données d'entrée et les données de sortie sont souvent difficiles à déterminer, si bien que la stabilité et la complexité des modèles d'IA posent un défi majeur. Les institutions financières doivent s'assurer que toutes les parties prenantes (utilisateurs, développeurs et fonctions de contrôle, notamment) participent à la conception et à la mise en œuvre des modèles d'IA. Un manque de communication entre les concepteurs et les utilisateurs, par exemple, risquerait de se traduire par des problèmes de spécifications, par des erreurs d'hypothèses et par une mauvaise utilisation.

Les modèles d'IA doivent être explicables, pour que les parties prenantes comprennent comment ils prennent leurs décisions. Les institutions financières doivent s'assurer d'un niveau d'explicabilité approprié pour informer les utilisateurs internes et les clients et pour satisfaire à leurs obligations de conformité et de gouvernance.

L'explicabilité est encore plus essentielle pour l'IA générative que pour les modèles d'IA et d'apprentissage automatique traditionnels. L'adoption rapide de l'IA générative, y compris des GML, augmente encore les risques liés à l'explicabilité de ces modèles. Il s'agit d'un enjeu fondamental pour les modèles d'apprentissage profond.

3.3 Risques juridiques, éthiques et de réputation

Les institutions financières gagneraient à adopter une approche globale de gestion des risques associés à l'IA. En se contentant de se conformer aux exigences juridiques minimales d'un territoire donné, elles s'exposent à des risques d'atteinte à leur réputation. Avec l'accélération de l'innovation, l'incertitude réglementaire peut poser des problèmes.

La protection des renseignements personnels et le consentement des consommateurs doivent avoir la priorité. Les institutions financières doivent informer leurs clients et les prévenir clairement dans les cas où l'IA a des répercussions sur eux, et le client doit consentir à l'utilisation de ses données. Les institutions financières doivent notamment faire preuve de transparence à l'égard de leurs pratiques de vente ciblées.

Les biais constituent un sujet complexe et multidimensionnel et peuvent être difficiles à corriger dans la pratique. Ils peuvent persister même après suppression des renseignements personnels. Ce que l'on perçoit comme un biais est parfois le résultat inévitable d'une stratification du risque à partir de variables permises. Il y a habituellement apparition d'un biais de discrimination lorsque l'utilisation de variables de substitution a priori anodines (comme le nom ou le code postal) donne lieu à l'inférence accidentelle de caractéristiques protégées (comme la race ou la religion) ou lorsque les décisions humaines qui ont servi à alimenter le modèle sont elles-mêmes biaisées. Cela peut entraîner des risques juridiques, de réputation ou d'exploitation pour les institutions financières. Celles-ci doivent procéder à une évaluation proactive de ces biais, en procédant par exemple à un suivi constant des modèles d'IA ayant une incidence sur les clients, notamment en matière de tarification ou de crédit. Pour éviter les biais, il conviendra de veiller à utiliser des données représentatives et de faire affaire avec des équipes multidisciplinaires et diversifiées.

La détection des biais soulève un dilemme : pour être efficace, elle nécessite la collecte de données de nature délicate comme la race ou la religion. Même lorsque les clients acceptent de fournir ces données, il y a un risque d'atteinte à la confidentialité des données. La nouvelle loi sur l'intelligence artificielle de l'Union européenne prévoit une exception au Règlement général sur la protection des données qui permet de recueillir des renseignements personnels sur certains éléments comme la race et le genre dans le but d'éliminer les biais des algorithmes d'IA.

L'incapacité à assumer la responsabilité des biais et des problèmes d'équité des modèles externes peut donner lieu à des risques juridiques et de réputation. L'institution financière qui ne prend pas la responsabilité des activités et fonctions commerciales et des services fournis par des tiers encourt des conséquences graves en cas de défaillance d'un modèle. Les institutions financières ont donc intérêt à évaluer et à atténuer ces risques à chaque fois que des clients risquent d'être touchés.

3.4 Risques liés aux tiers

La plupart des institutions financières utilisent des modèles et des systèmes d'IA de prestataires externes. La mainmise de ces grands spécialistes sur le secteur peut occasionner un risque de concentration, comme on a pu le voir lors de la panne informatique mondiale de juillet 2024 (en anglais seulement), qui a occasionné une perte financière estimée à 5,4 G$. S'il est possible de limiter ce risque de concentration, il n'en demeure pas moins que les pannes et les menaces à l'intégrité des données doivent faire l'objet d'un suivi.

Chaque institution financière doit veiller à ce que ses fournisseurs externes respectent ses normes internes, et ce n'est pas une mince affaire. C'est qu'elle doit posséder les connaissances techniques pour s'en assurer et que ces entreprises externes sont soucieuses de protéger leurs droits de propriété intellectuelle. Il est toutefois essentiel qu'elles exercent leurs activités et offrent leurs services en toute sécurité et en conformité, d'une part avec les lois et la réglementation en vigueur, et d'autre part avec les politiques, normes et processus internes de chacune des institutions financières. Celles-ci sont d'ailleurs responsables des résultats des systèmes d'IA de tiers qu'elles utilisent pour vendre ou promouvoir leurs produits et services.

Les logiciels et bibliothèques de source ouverte posent également des risques que les institutions financières pourront atténuer en se dotant de cadres et de contrôles de gestion du risque à l'efficacité éprouvée qui devront être soumis aux mêmes normes de gouvernance que les modèles internes ou de tiers.

Les modèles d'IA augmentent la dépendance à l'infonuagique, puisqu'ils sont pour la plupart hébergés dans le nuage ou dans un environnement hybride. Les risques en cas de panne prolongée sont majeurs, même lorsque les ententes de niveau de service prévoient des protections. Outre la complexité des infrastructures de données et des systèmes hérités, la sécurité des données dans le nuage constitue elle aussi un aspect important de la gouvernance de données en IA et requiert à ce titre une attention particulière.

3.5 Risques opérationnels et cyberrisques

L'intelligence artificielle peut bien sûr permettre aux institutions financières d'améliorer leur efficacité opérationnelle, mais elle constitue également une source de risque. En intégrant l'IA à leurs processus, procédures et contrôles, elles augmentent également leurs risques opérationnels. L'interdépendance des systèmes et des données se traduit par une complexité qui peut donner lieu à des problèmes inattendus et compromettre la résilience opérationnelle. En l'absence de mesures de sécurité adéquates, le recours à l'IA peut entraîner une augmentation du risque de cyberattaques. Une défaillance des systèmes d'IA peut rapidement se traduire par des risques financiers. Les institutions financières doivent donc mettre en place des protections suffisamment efficaces autour de ces systèmes pour en assurer la résilience.

L'utilisation à l'interne d'outils d'IA peut poser des problèmes de cybersécurité, compte tenu des risques d'empoisonnement de données et de fuite de renseignements protégés. Le ministère britannique des sciences, de l'innovation et de la technologie a fait le point sur les cyberrisques liés à l'IA dans son rapport de mai 2024, intitulé Cyber Security Risks to Artificial Intelligence (en anglais seulement). Les institutions financières qui utilisent des GML personnalisés à partir de données internes courent davantage de risque de fuite de données sur leurs clients ou de secrets commerciaux.

L'existence de relations complexes avec des tiers constitue elle aussi une source importante de cyberrisques. La transmission de données à des prestataires externes augmente le risque d'interception, même lorsque le tiers ne stocke pas les données. L'opacité de ces modèles augmente le risque de nouvelles attaques, difficiles à prévoir. Les modèles d'IA peuvent être victimes de différents types d'attaques comme l'empoisonnement de données, les fuites de données, les attaques d'évasion et l'extraction de modèles.

4 Risques externes

On voit également émerger un certain nombre de risques systémiques associés à l'IA, dans le sens où l'avancée inexorable des technologies liées à l'IA risque d'avoir des effets systémiques. La percolation de l'IA dans l'ensemble de l'économie et sa récupération par des auteurs de menace peuvent constituer de nouveaux risques pour la stabilité financière.

4.1 Progrès technologiques de l'IA

L'IA peut déjà accomplir bien des tâches à la place de l'être humain et ce n'est qu'un débutNote de bas de page 11. Les fournisseurs de matériel informatique améliorent par ailleurs sans cesse la puissance des processeurs graphiques (GPU) qui permettent d'alimenter l'IA générative. Or, les « lois d'échelle » indiquent qu'une augmentation de la puissance de calcul donnera naissance à des modèles toujours plus importants et plus puissants. Les chercheurs bonifient également les algorithmes et la qualité des données servant à alimenter les modèles d'IA afin d'en améliorer la fiabilité, d'en réduire les hallucinations et d'en accroître les capacités. Les géants de la technologie investissent tous massivement pour créer des agents d'IA autonomes.

4.2 Augmentation des cyberrisques et des menaces de fraude

Le Fonds monétaire international (FMI) estime que le coût des cyberattaques majeures subies par les institutions financières a quadruplé ces dernières années. Cette hausse des cyberrisques est notamment liée à l'IA, et plus particulièrement à l'IA générative, qui facilite ce genre d'attaques.

Les auteurs de menace ont en effet de plus en plus recours à l'IA générative (en anglais seulement) :

-

Ils utilisent l'hypertrucage vidéo et audio pour procéder à des vols d'identité, contourner les contrôles de sécurité ou se livrer à escroqueries. À l'échelle mondiale, 91 % des institutions financières pensent à renoncer à l'identification vocale en raison des risques d'hypertrucage audio liés à l'IA (en anglais seulement).

- Le vol d'identité et la création d'identité synthétique peuvent servir à usurper l'identité de particuliers ou à ouvrir des comptes frauduleux à l'aide de fausses identitésNote de bas de page 12.

- Les pirates peuvent désormais produire des courriels ou des SMS aux fins d'hameçonnage ciblé à grande échelle, l'IA leur permettant de générer automatiquement des messages hyperpersonnalisés et crédibles.

- Ils peuvent désormais programmer rapidement de nouveaux logiciels malveillants ou modifier des attaques existantes.

- Parce qu'ils peuvent repérer plus rapidement les failles des réseaux et des systèmes des institutions financières, il leur faut désormais beaucoup moins de temps pour passer à l'attaque.

- Ils peuvent exploiter les modèles d'IA des institutions financières par empoisonnement de données, fuite de données lors de l'inférence, attaques d'évasion et extraction de modèles.

Les attaques sur les petites institutions financières pourraient se multiplier. Selon le FMI, elles étaient habituellement moins souvent ciblées parce que leur empreinte numérique était plus faible et qu'elles ne rapportaient pas beaucoup au regard du temps consacré à l'organisation de l'attaque. L'avènement de l'IA générative vient toutefois changer la donne en permettant aux pirates d'automatiser davantage leurs attaques. Les attaques contre les petites institutions pourraient donc devenir plus rentables.

4.3 Risques financiers et d'exploitation

Les institutions financières qui n'adopteront pas l'IA risquent de se retrouver confrontées à un certain nombre de pressions financières et concurrentielles à terme. Si l'IA devait transformer le paysage financier, les sociétés qui n'auraient pas fait le saut à temps pourraient avoir du mal à rester dans la course faute de compétences et de connaissances suffisantes à l'interne.

Quels risques d'exploitation découleront-ils de l'IA? On ne le sait pas exactement et cela constitue un problème en soi. S'ils sont relativement limités à l'heure actuelle, ils pourraient augmenter avec le temps si d'autres institutions financières ou de nouveaux venus parvenaient à mieux tirer parti des progrès technologiques pour gagner des parts de marché. Les grandes sociétés technologiques investissent massivement dans le développement d'agents autonomes qui risquent d'entraîner la disparition de différentes sources de revenus dont dépendent actuellement les institutions financières.

4.4 Nouveaux risques de crédit, de marché et de liquidité à prévoir

Les répercussions macroéconomiques de l'IA risquent de se traduire par des pertes de crédit. Le FMI estime que l'automatisation par l'IA risque de toucher 60 % des emplois dans les économies avancées. Si une proportion substantielle de ces emplois devait disparaître, les particuliers touchés risquent d'avoir du mal à rembourser leurs prêts, ce qui se traduirait par une hausse du risque de crédit pour les institutions financières. Des pertes sur les prêts aux entreprises pourraient également survenir si les perturbations liées à l'IA devaient faire des gagnants et des perdants dans certains secteurs.

L'IA pourrait également avoir un effet sur les risques de marché et de liquidité. Gary Gensler, président de la Securities and Exchange Commission (SEC) des États-Unis, met en garde contre le comportement mimétique auquel pourrait mener l'adoption de l'IA par les fonds de couverture et par d'autres sociétés. Il n'est pas non plus exclu que la négociation algorithmique donne lieu à des krachs éclairs, comme celui que nous avons connu en 2010. Parce que les modèles de négociation fondés sur l'intelligence artificielle seront de plus en plus sensibles aux indicateurs avancés, il risque de se produire un phénomène de récursivité de nature à accentuer la volatilité de toutes les catégories d'actifs. L'IA pourrait aussi avoir des répercussions sur la liquidité de financement dans un avenir proche. Dans certains pays, les entreprises de technologie financière permettent déjà à leurs clients de transférer automatiquement leurs dépôts d'une institution financière à l'autre dans le but de faire plus d'intérêts. Si les agents d'IA pouvaient s'en charger, la stabilité traditionnelle des dépôts de particuliers qui constituent la source de financement principale des ID pourrait être compromise.

5 Gestion du risque lié à l'IA : les erreurs à éviter

- Une gestion du risque qui n'évolue pas aussi vite que l'adoption de l'IA

-

Le plus gros risque que fait peser l'IA concerne probablement la gouvernance du risque dans son ensemble. Le caractère inédit de la technologie commande agilité et vigilance dans la gestion du risque, surtout dans les secteurs d'activité qui utilisent l'IA, mais où la gouvernance du risque de modélisation n'est pas habituelle.

- Absence de supervision de la gestion du risque lié à l'IA

-

On risque de voir apparaître des lacunes en matière de gestion du risque si une institution financière ne considère les risques liés à l'IA que de certains points de vue, sans lien entre eux (gestion du risque de modélisation ou du cyberrisque, par exemple). La mise en place de cadres organisationnels, de gouvernance et opérationnels adéquats peut par ailleurs offrir d'autres avantages, surtout si elle s'accompagne d'une approche multidisciplinaire, qui favorise la collaboration et la communication entre tous les intervenants de la société.

- Non prise en compte de tous les risques tout au long du cycle de vie du modèle d'IA

-

L'analyse de risque initiale des modèles d'IA est une pratique courante. Mais, si elle ne porte que sur une seule catégorie de risque, elle pourrait passer à côté d'autres risques (voir ci-dessus). Des réévaluations périodiques sont donc nécessaires pour veiller à l'atténuation des risques.

- Absence de mesures d'urgence ou de protection face aux modèles d'IA

-

En raison des problèmes d'explicabilité rencontrés par nombre de modèles d'IA, ceux-ci risquent de ne pas se comporter comme prévu. Ils nécessitent donc des mesures de contrôle, comme une intervention humaine, un suivi des rendements, des systèmes de sauvegarde, des alertes, des opérations d'apprentissage automatique et des limites d'utilisation des renseignements personnels.

- Absence de mise à jour des cadres et des mesures de contrôle du risque lié à l'IA générative

-

Le recours aux modèles d'IA générative peut amplifier certains risques (explicabilité, biais, dépendance à l'égard de tiers, par exemple). L'utilisation par les employés d'outils d'IA générative de tiers accessibles au public constitue elle aussi un risque. Il y aura donc lieu de mettre en place des mesures de contrôle portant spécifiquement sur l'IA générative (suivi accru, formation des employés sur l'utilisation des outils, mesures pour empêcher l'intégration de données confidentielles dans les requêtes, etc.).

- Insuffisance de la formation sur l'IA offerte aux employés

-

Parce que l'IA est un domaine où tout change très vite, on constate souvent un manque général de connaissances et de compétences qui peut conduire à prendre de mauvaises décisions ou se traduire par une augmentation des risques. L'augmentation de l'offre de formation, à tous les niveaux de l'entreprise, permet généralement de mieux sensibiliser les employés aux risques, de les aider à faire une meilleure utilisation des outils et de s'assurer que les utilisateurs connaissent les limites et les contrôles applicables. De telles formations seront particulièrement profitables pour les employés qui utilisent directement la technologie et pour les cadres décideurs.

- Adoption de l'IA sans analyse stratégique

-

Plusieurs institutions financières pensent qu'un retard dans l'adoption des nouvelles technologies peut entraîner des risques stratégiques et d'exploitation. D'autres évitent l'IA à cause de l'incertitude. On ne devrait adopter l'IA qu'au terme d'une analyse stratégique réfléchie des avantages et des risques, en fonction de la situation spécifique de chaque institution financière.

- Faire fi des risques liés à l'IA sous prétexte que l'on ne l'utilise pas

-

Même si elles n'ont pas recours à l'intelligence artificielle, les institutions financières auraient avantage à garder leurs cadres de risque, leurs formations ou leurs processus de gouvernance à jour et à tenir compte des risques liés à l'IA. Cela les aidera à atténuer les risques, comme les risques d'exploitation, les risques liés à une mauvaise utilisation des outils d'IA par les employés et les risques externes liés à l'IA.

6 Les autorités de réglementation doivent elles aussi suivre la cadence

Le BSIF et l'ACFC sont déterminés à réagir de façon dynamique et proactive à l'évolution de l'environnement de risque, dans la mesure où l'incertitude entourant les répercussions de l'IA constitue également un défi pour les autorités de réglementation. Les réponses au questionnaire sur l'IA montrent que les pratiques de gestion et de gouvernance du risque varient largement d'une institution financière à l'autre : il y aurait donc peut-être lieu d'approfondir le dialogue et de promouvoir l'adoption de pratiques exemplaires.

Les institutions financières aspirent à des règles plus claires et plus uniformes. Beaucoup nous disent attendre la version finale de la ligne directrice E-23 du BSIF sur la gestion du risque de modélisation à l'échelle de l'entreprise, de la Loi sur l'intelligence artificielle et les données (C-27) et d'autres lignes directrices sur l'IA avant de prendre véritablement le virage de l'intelligence artificielle.

Un deuxième forum sur l'intelligence artificielle dans le secteur financier est en cours de planification. Les institutions financières, le milieu universitaire et les organismes de réglementation pairs avaient répondu massivement présents à la première édition qui avait débouché sur la publication de 2023. Les principes EDGE présentés dans le rapport du FIASSF sur l'IA responsable ont été bien accueillis, mais ils ne faisaient peut-être pas suffisamment de place aux défis et aux arbitrages auxquels les institutions financières se heurtent en pratique. Le BSIF, en partenariat avec le GRI et les acteurs du milieu, s'efforcera de poursuivre le travail déjà amorcé lors des prochains ateliers du Forum, dans le but d'instaurer des pratiques exemplaires plus spécifiques.

7 Conclusion

Les institutions financières canadiennes ont résolument pris le virage de l'intelligence artificielle ces dernières années. La tendance devrait se poursuivre et elles devraient adapter leurs stratégies pour éviter de se laisser distancer par la concurrence. L'adoption de l'IA suppose différents types de risques, ce qui amènera un lot de défis pour les institutions financières au cours des prochaines années.

-

Les institutions financières doivent non seulement procéder à une définition et à une évaluation rigoureuses des risques, mais également se doter d'équipes multidisciplinaires et diversifiées en raison de la portée, de l'ampleur et de la complexité de certaines applications de l'IA.

- Les institutions financières doivent être ouvertes, honnêtes et transparentes dans leurs relations avec leurs clients en matière d'IA et de données.

- L'IA est appelée à gagner du terrain dans les institutions financières et dans la société en général. Compte tenu du dynamisme du domaine et de l'interconnexion entre les systèmes et les données ainsi qu'entre les différents risques, les institutions financières ont intérêt à se préparer et à se doter d'une stratégie en matière d'intelligence artificielle, même si elles ne comptent pas recourir à l'IA à brève échéance.

- L'IA constituant un risque transversal, elle doit être considérée globalement et faire l'objet de normes de gestion du risque intégrant l'ensemble des risques afférents. Parce que l'IA se développe rapidement, les institutions financières n'auront d'autre choix que de se montrer proactives dans leur gouvernance du risque, leurs approches stratégiques et leur gestion du risque. Conseils d'administration et organes de supervision doivent répondre présents et prendre la mesure des avantages et des risques pour veiller à ce que leurs institutions soient bien préparées.